Wahrscheinlichkeitsfunktion

Eine Wahrscheinlichkeitsfunktion, auch Zähldichte genannt,[1] ist eine spezielle reellwertige Funktion in der Stochastik. Wahrscheinlichkeitsfunktionen werden zur Konstruktion und Untersuchung von Wahrscheinlichkeitsverteilungen, genauer diskreten Wahrscheinlichkeitsverteilungen verwendet. Dabei kann jeder diskreten Wahrscheinlichkeitsverteilung eine eindeutige Wahrscheinlichkeitsfunktion zugeordnet werden. Umgekehrt definiert jede Wahrscheinlichkeitsfunktion eine eindeutig bestimmte diskrete Wahrscheinlichkeitsverteilung.

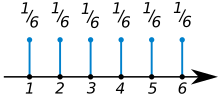

In den meisten Fällen werden Wahrscheinlichkeitsfunktionen auf den natürlichen Zahlen definiert. Sie ordnen dann jeder Zahl die Wahrscheinlichkeit zu, dass diese Zahl auftritt. So würde bei der Modellierung eines fairen Würfels die Wahrscheinlichkeitsfunktion den Zahlen von eins bis sechs jeweils den Wert zuordnen und allen anderen die Null.

Aus der Sicht der Maßtheorie handelt es sich bei Wahrscheinlichkeitsfunktionen um spezielle Dichtefunktionen (im Sinne der Maßtheorie) bezüglich des Zählmaßes. Diese werden im allgemeineren Kontext auch Gewichtsfunktionen genannt.[2]

Definition

Definition Wahrscheinlichkeitsfunktion: Für eine diskrete Zufallsvariable ist die Wahrscheinlichkeitsfunktion für definiert durch

Zur Konstruktion einer Wahrscheinlichkeitsverteilung

Gegeben sei ein Wahrscheinlichkeitsraum sowie eine Funktion mit folgenden Eigenschaften:

- sodass

Die Funktion ordnet also jeder natürlichen Zahl eine reelle Zahl zwischen null und eins zu und ist normiert in dem Sinne, dass sich die Funktionswerte zu eins aufsummieren.

Dann heißt eine Wahrscheinlichkeitsfunktion und definiert durch

eine eindeutig bestimmte Wahrscheinlichkeitsverteilung auf den natürlichen Zahlen , versehen mit der Potenzmenge als der Sigma-Algebra (Ereignissystem).

Insbesondere gilt aufgrund der Sigma-Additivität des Wahrscheinlichkeitsmaßes :

Aus folgt des Weiteren:

Es ist hierbei zu beachten, dass als Wahrscheinlichkeitsverteilung lediglich Mengen aus als Argumente zulässt, während die Argumente der Wahrscheinlichkeitsfunktion stets durch einzelne natürliche Zahlen als Elemente von dargestellt werden. Das Wahrscheinlichkeitsmaß hingegen ist definiert als die Abbildung:

Aus Wahrscheinlichkeitsverteilungen abgeleitet

Gegeben sei eine Wahrscheinlichkeitsverteilung auf den natürlichen Zahlen , versehen mit , und sei eine Zufallsvariable mit Werten in . Dann heißt

definiert durch

die Wahrscheinlichkeitsfunktion von . Analog heißt

definiert durch

die Wahrscheinlichkeitsfunktion von

Beispiele

Eine typische Wahrscheinlichkeitsfunktion ist

für eine natürliche Zahl und eine reelle Zahl . Die Normiertheit folgt hier direkt aus dem binomischen Lehrsatz, denn es ist

- .

Die so erzeugte Wahrscheinlichkeitsverteilung ist die Binomialverteilung.

Eine weitere klassische Wahrscheinlichkeitsfunktion ist

- für

und ein . Hier folgt die Normiertheit aus der geometrischen Reihe, denn es ist

- .

Die so erzeugte Wahrscheinlichkeitsverteilung ist die Geometrische Verteilung.

Allgemeine Definition

Die Definition lässt sich von den natürlichen Zahlen auf beliebige höchstens abzählbare Mengen ausweiten. Ist solch eine Menge und ist

mit

- ,

so definiert durch

- für alle

eine eindeutig bestimmte Wahrscheinlichkeitsverteilung auf .[3] Ist umgekehrt eine Wahrscheinlichkeitsverteilung auf und eine Zufallsvariable mit Werten in , so heißen

- definiert durch

und

- definiert durch

die Wahrscheinlichkeitsfunktion von beziehungsweise .[4]

Alternative Definition

Manche Autoren definieren zuerst reelle Folgen mit für alle und

und nennen diese Folgen Wahrscheinlichkeitsvektoren[5] oder stochastische Folgen[6][7].

Eine Wahrscheinlichkeitsfunktion wird dann definiert als

gegeben durch

- für alle

Umgekehrt definiert dann jede Wahrscheinlichkeitsverteilung oder Zufallsvariable auf auch eine stochastische Folge/Wahrscheinlichkeitsvektor über beziehungsweise

Andere Autoren nennen bereits die Folge eine Zähldichte.[8]

Weitere Beispiele

Typisches Beispiel für Wahrscheinlichkeitsfunktionen auf beliebigen Mengen ist die diskrete Gleichverteilung auf einer endlichen Menge . Sie besitzt dann per Definition die Wahrscheinlichkeitsfunktion

- für alle .

Der Zugang über die stochastischen Folgen erlaubt die folgende Konstruktion von Wahrscheinlichkeitsfunktionen: Ist eine beliebige (höchstens abzählbare) Folge von positiven reellen Zahlen mit Indexmenge gegeben, für die

gilt, so definiert man

- .

Dann ist eine stochastische Folge und definiert damit auch eine Wahrscheinlichkeitsfunktion. Betrachtet man zum Beispiel die Folge

- für ,

so ist

- .

Somit ist die Normierungskonstante und als Wahrscheinlichkeitsfunktion ergibt sich

- .

Dies ist die Wahrscheinlichkeitsfunktion der Poisson-Verteilung.

Bestimmung von Kennzahlen durch Wahrscheinlichkeitsfunktionen

Viele der wichtigen Kennzahlen von Zufallsvariablen und Wahrscheinlichkeitsverteilungen lassen sich bei Existenz der Wahrscheinlichkeitsfunktion direkt aus dieser herleiten.

Erwartungswert

Ist eine Zufallsvariable mit Werten in und Wahrscheinlichkeitsfunktion , so ist der Erwartungswert gegeben durch

- .

Er existiert immer, kann aber auch unendlich sein. Ist allgemeiner eine höchstens abzählbare Teilmenge der reellen Zahlen und eine Zufallsvariable mit Werten in und Wahrscheinlichkeitsfunktion so ist der Erwartungswert gegeben durch

falls die Summe existiert.

Varianz

Analog zum Erwartungswert lässt sich auch die Varianz direkt aus der Wahrscheinlichkeitsfunktion herleiten. Sei dazu

der Erwartungswert. Ist dann eine Zufallsvariable mit Werten in und Wahrscheinlichkeitsfunktion , so ist die Varianz gegeben durch

oder aufgrund des Verschiebungssatzes äquivalent dazu

Entsprechend gilt im allgemeineren Fall einer Zufallsvariable mit Werten in (vgl. oben), dass

Auch hier gelten alle Aussagen nur, wenn die entsprechenden Summen existieren.

Modus

Für diskrete Wahrscheinlichkeitsverteilungen wird der Modus direkt über die Wahrscheinlichkeitsfunktion definiert: Ist eine Zufallsvariable mit Werten in und Wahrscheinlichkeitsfunktion oder ist eine Wahrscheinlichkeitsverteilung auf mit Wahrscheinlichkeitsfunktion , so heißt ein Modus oder Modalwert von oder , wenn

ist. Ist etwas allgemeiner eine höchstens abzählbare Menge gegeben, deren Elemente in aufsteigender Ordnung sortiert sind, das heißt , so heißt ein ein Modus oder Modalwert, wenn

gilt.[9]

Eigenschaften und aufbauende Begriffe

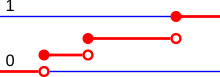

Verteilungsfunktionen und Wahrscheinlichkeitsfunktionen

Ist eine Wahrscheinlichkeitsfunktion auf , so ist die Verteilungsfunktion des entsprechenden Wahrscheinlichkeitsmaßes gegeben als

- .

Dabei bezeichnet die Abrundungsfunktion, das heißt ist größte ganze Zahl, die kleiner oder gleich ist.

Ist auf einer höchstens abzählbaren Teilmenge der reellen Zahlen definiert, also auf , so ist die Verteilungsfunktion des Wahrscheinlichkeitsmaßes definiert durch

- .

Beispiel hierfür ist .

Faltung und Summe von Zufallsvariablen

Für Wahrscheinlichkeitsverteilungen mit Wahrscheinlichkeitsfunktionen kann die Faltung (von Wahrscheinlichkeitsverteilungen) auf die Faltung (von Funktionen) der entsprechenden Wahrscheinlichkeitsfunktionen zurückgeführt werden. Sind Wahrscheinlichkeitsverteilungen mit Wahrscheinlichkeitsfunktionen und , so ist

- .

Hierbei bezeichnet die Faltung von und und die Faltung der Funktionen und . Die Wahrscheinlichkeitsfunktion der Faltung zweier Wahrscheinlichkeitsverteilungen ist somit genau die Faltung der Wahrscheinlichkeitsfunktionen der Wahrscheinlichkeitsverteilungen.

Diese Eigenschaft überträgt sich direkt auf die Summe von stochastisch unabhängigen Zufallsvariablen. Sind zwei stochastisch unabhängige Zufallsvariablen mit Wahrscheinlichkeitsfunktionen und gegeben, so ist

- .

Die Wahrscheinlichkeitsfunktion der Summe ist somit die Faltung der Wahrscheinlichkeitsfunktionen der einzelnen Zufallsvariablen.

Wahrscheinlichkeitserzeugende Funktion

Auf lässt sich jeder Wahrscheinlichkeitsverteilung eine wahrscheinlichkeitserzeugende Funktion zuordnen. Dies ist ein Polynom oder eine Potenzreihe mit der Wahrscheinlichkeitsfunktion als Koeffizienten. Sie ist somit definiert als

für die Wahrscheinlichkeitsfunktion einer Wahrscheinlichkeitsverteilung . Die wahrscheinlichkeitserzeugende Funktion einer Zufallsvariable wird analog definiert.

Wahrscheinlichkeitserzeugende Funktionen erleichtern die Untersuchung von und das Rechnen mit Wahrscheinlichkeitsverteilungen. So ist beispielsweise die wahrscheinlichkeitserzeugende Funktion der Faltung zweier Wahrscheinlichkeitsverteilungen genau das Produkt der wahrscheinlichkeitserzeugenden Funktionen der einzelnen Wahrscheinlichkeitsverteilungen. Ebenso finden sich wichtige Kennzahlen wie der Erwartungswert und die Varianz in den Ableitungen der wahrscheinlichkeitserzeugenden Funktionen wieder.

Literatur

- Hans-Otto Georgii: Stochastik. Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. Walter de Gruyter, Berlin 2009, ISBN 978-3-11-021526-7, doi:10.1515/9783110215274.

- Achim Klenke: Wahrscheinlichkeitstheorie. 3. Auflage. Springer-Verlag, Berlin Heidelberg 2013, ISBN 978-3-642-36017-6, doi:10.1007/978-3-642-36018-3.

- David Meintrup, Stefan Schäffler: Stochastik. Theorie und Anwendungen. Springer-Verlag, Berlin Heidelberg New York 2005, ISBN 978-3-540-21676-6, doi:10.1007/b137972.

- Klaus D. Schmidt: Maß und Wahrscheinlichkeit. 2., durchgesehene Auflage. Springer-Verlag, Heidelberg Dordrecht London New York 2011, ISBN 978-3-642-21025-9, doi:10.1007/978-3-642-21026-6.

- Claudia Czado, Thorsten Schmidt: Mathematische Statistik. Springer-Verlag, Berlin Heidelberg 2011, ISBN 978-3-642-17260-1, doi:10.1007/978-3-642-17261-8.

- Ulrich Krengel: Einführung in die Wahrscheinlichkeitstheorie und Statistik. Für Studium, Berufspraxis und Lehramt. 8. Auflage. Vieweg, Wiesbaden 2005, ISBN 3-8348-0063-5, doi:10.1007/978-3-663-09885-0.

Einzelnachweise

- ↑ Georgii: Stochastik. 2009, S. 18.

- ↑ Klenke: Wahrscheinlichkeitstheorie. 2013, S. 13.

- ↑ Schmidt: Maß- und Wahrscheinlichkeit. 2011, S. 196.

- ↑ Czado, Schmidt: Mathematische Statistik. 2011, S. 4.

- ↑ Klenke: Wahrscheinlichkeitstheorie. 2013, S. 13.

- ↑ Meintrup, Schäffler: Stochastik. 2005, S. 63.

- ↑ Schmidt: Maß- und Wahrscheinlichkeit. 2011, S. 234.

- ↑ Georgii: Stochastik. 2009, S. 18.

- ↑ A.V. Prokhorov: Mode. In: Michiel Hazewinkel (Hrsg.): Encyclopedia of Mathematics. Springer-Verlag und EMS Press, Berlin 2002, ISBN 1-55608-010-7 (englisch, encyclopediaofmath.org).

![{\displaystyle f(i)\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e858b4d8c2c8ad065703d13a47d25fda70b0fcae)

![{\displaystyle f\colon \Omega \to [0,1]\subset \mathbb {R} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/266474c89556eb677b774ad28b2f0f35d7e7b4a0)

![{\displaystyle \mathbb {P} \colon {\mathcal {A}}\to [0,1]\subset \mathbb {R} }](https://wikimedia.org/api/rest_v1/media/math/render/svg/30eb41b2d19aa55548b449e9ce79944f88e0fcd2)

![{\displaystyle f\colon \Omega \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8970817f50bfd1ffa3f538617ca394ecc19c255f)

![{\displaystyle f_{P}\colon \Omega \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/292ecd34080a3194456f9f0a4e4f673c61222355)

![{\displaystyle f_{X}\colon \Omega \to [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b4b302d3624a2ae2a94447f9b2388f3ef22816eb)

![{\displaystyle p_{i}\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/14760da7a7625a3070329a16c4c37033424871fe)